个人电脑,可以使用 Ollama 和 Chatbox 实现 DeepSeek R1 的本地 AI 智能助手,需要做以下事情:

- 安装 Ollama

- 配置 DeepSeek R1 模型

- 使用 Chatbox 与模型进行交互

1. 安装 Ollama

Ollama 是一个用于本地运行大型语言模型的工具。

可以通过以下步骤安装 Ollama:

1.1 下载 Ollama

- 访问 Ollama 的 GitHub 仓库 或官方网站,下载适合你操作系统的安装包

1.2 安装 Ollama

- Windows:双击下载的安装包,按照提示完成安装。

- macOS:将下载的 .dmg 文件拖到 Applications 文件夹中。

- Linux:使用包管理器或直接运行下载的安装脚本。

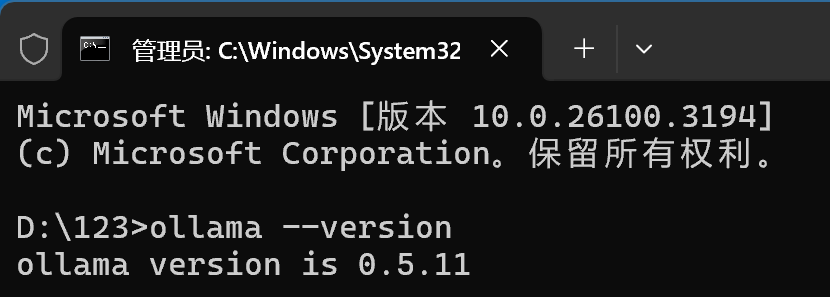

1.3 验证安装

命令提示符,输入ollama –version,输出版本号,确保安装成功。

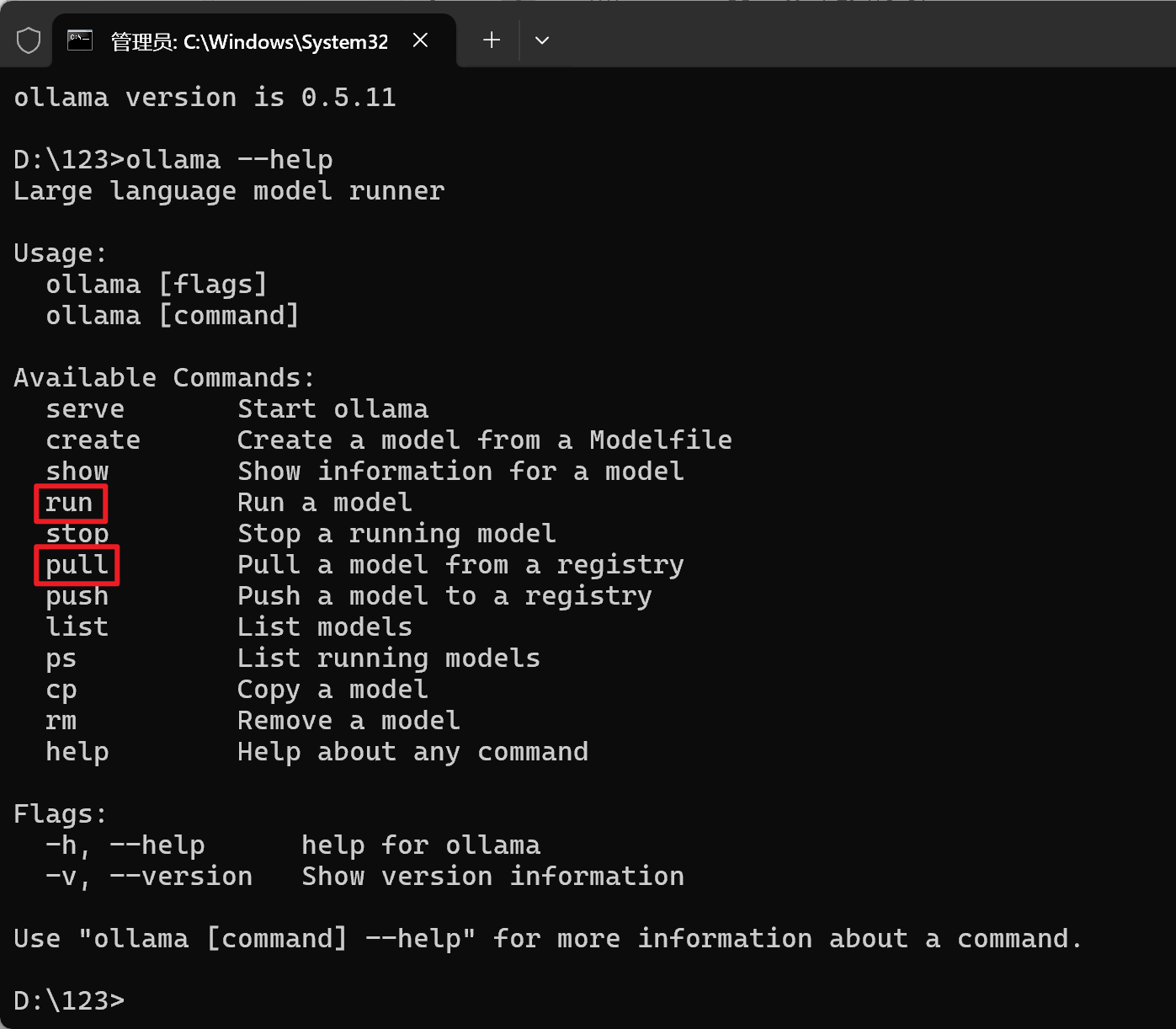

1.4 Ollama常用命令

2. 配置 DeepSeek R1 模型

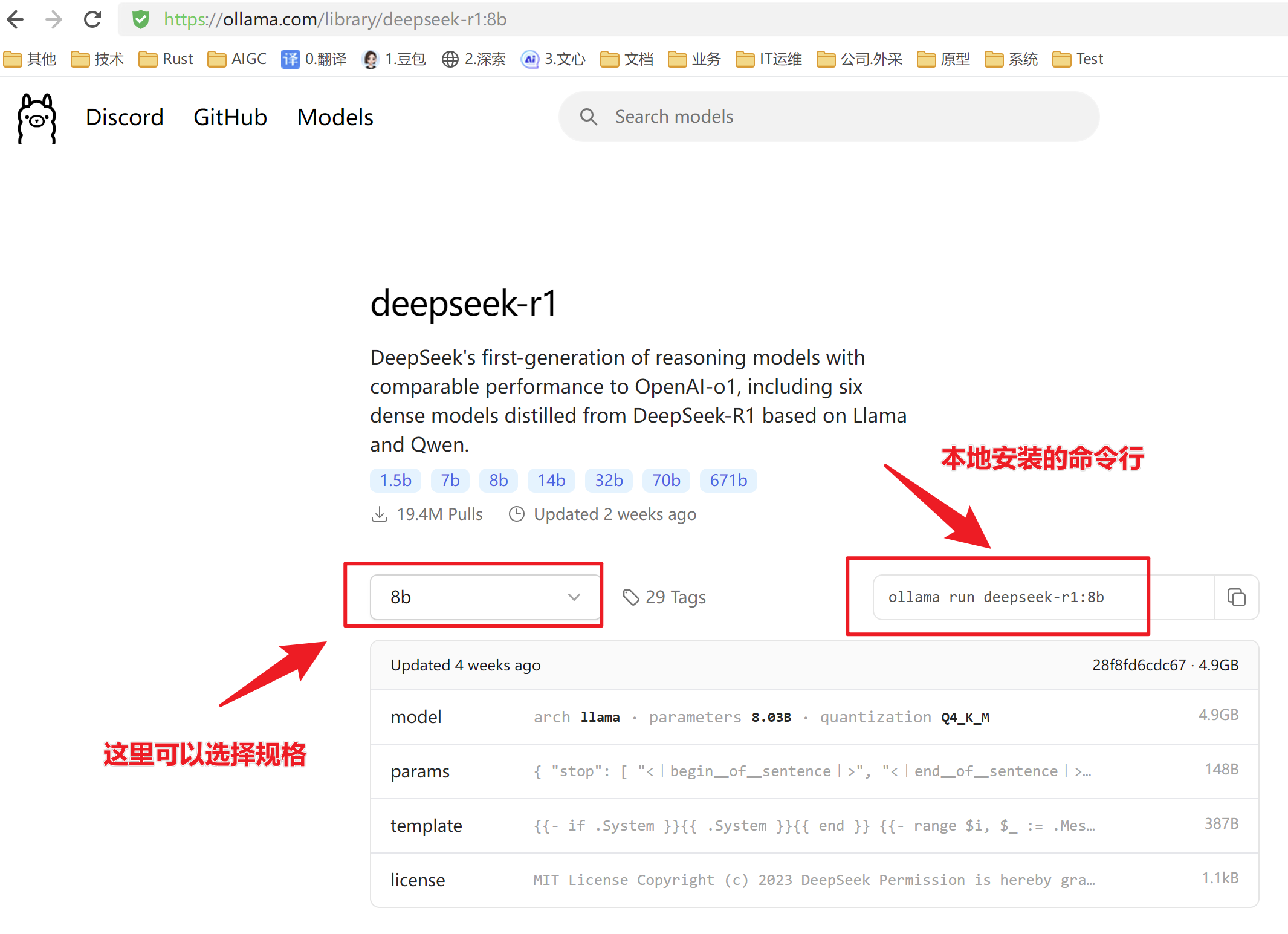

2.1 下载 DeepSeek R1 模型

从 Ollama的官方网站下载 DeepSeek R1 模型文件。

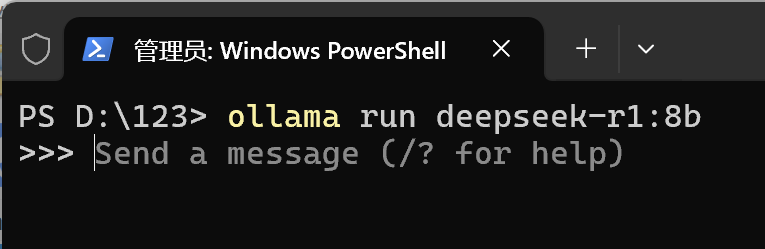

ollama run deepseek-r1:8b

2.2 启动模型

启动模型和下载模型是同一个命令,如果没有下载过的新模型会直接下载,下载完成后会直接运行,显示命令行提示符,如下图所示:

3.安装和配置Chatbox

Chatbox AI 是一款 AI 客户端应用和智能助手,支持众多先进的 AI 模型和 API,可在 Windows、MacOS、Android、iOS、Linux 和网页版上使用。

3.1 下载Chatbox

访问 Chatbox官网(https://chatboxai.app/),下载合适的安装包。

3.2 安装Chatbox

- Windows:双击下载的安装包,按照提示安装即可。

- MacOS:双击下载的 .dmg,然后拖到 Applications 文件夹中。

3.3 配置Chatbox

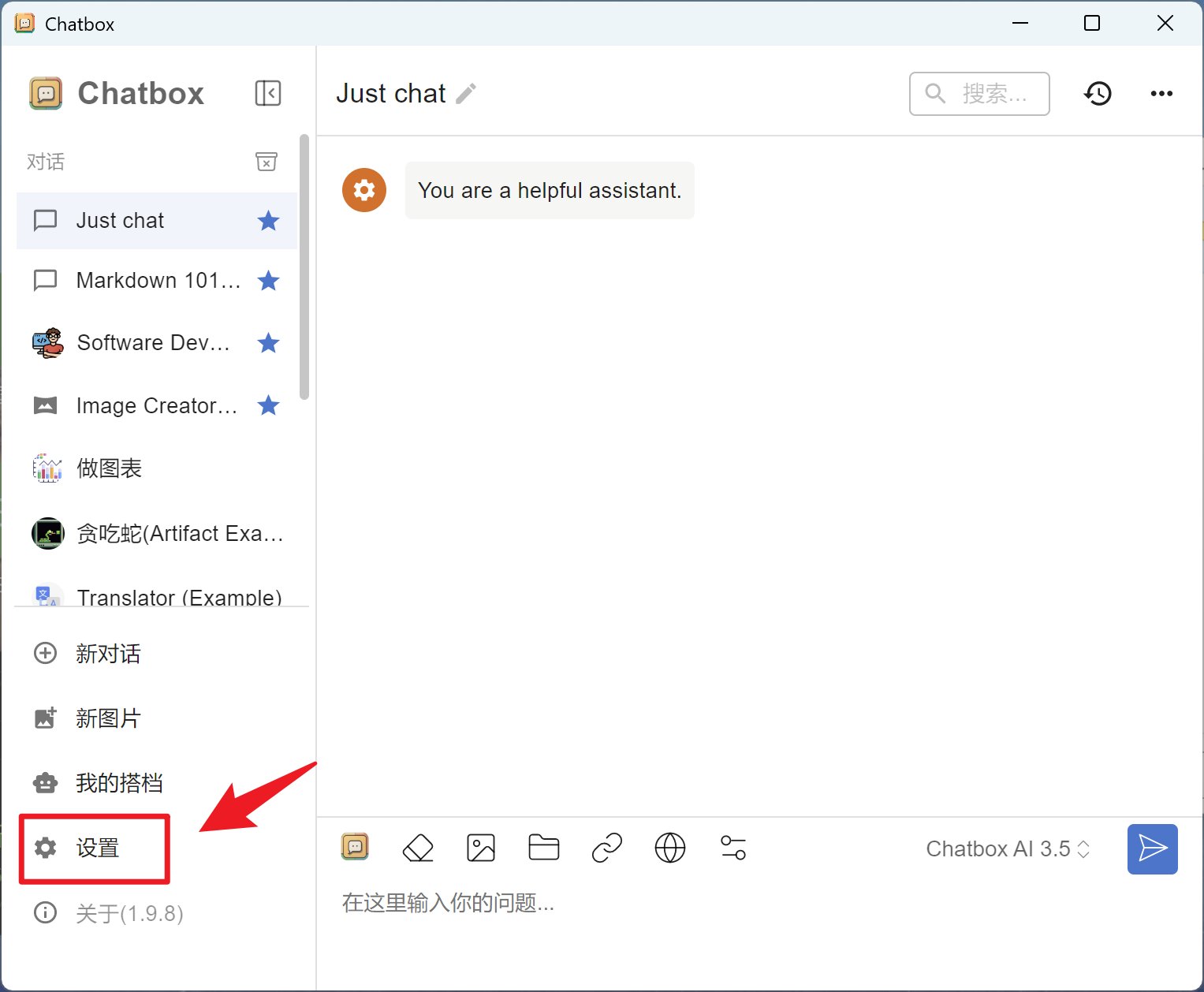

打开Chatbox,进入配置页面

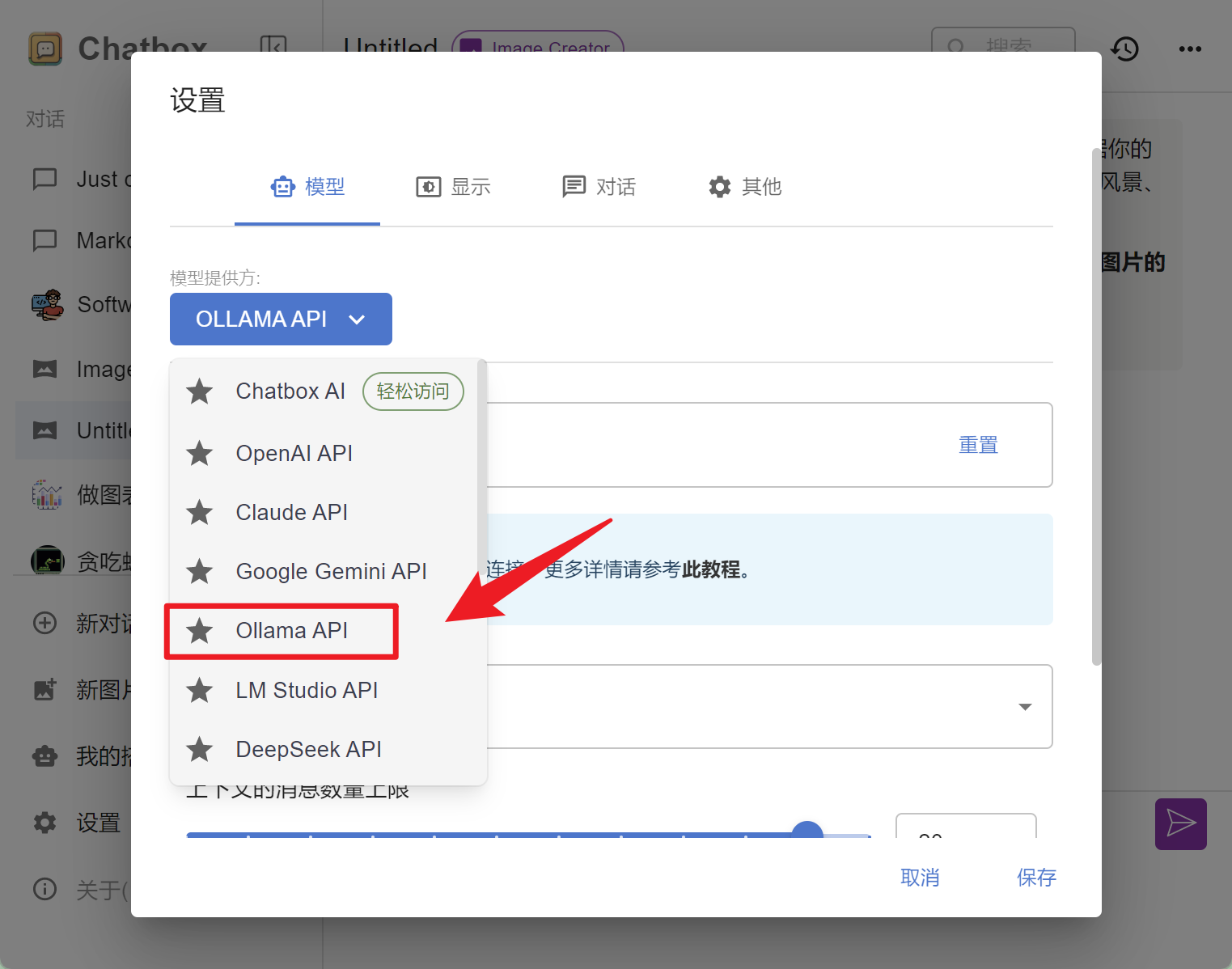

在“模型提供方”下拉选择“Ollama API”

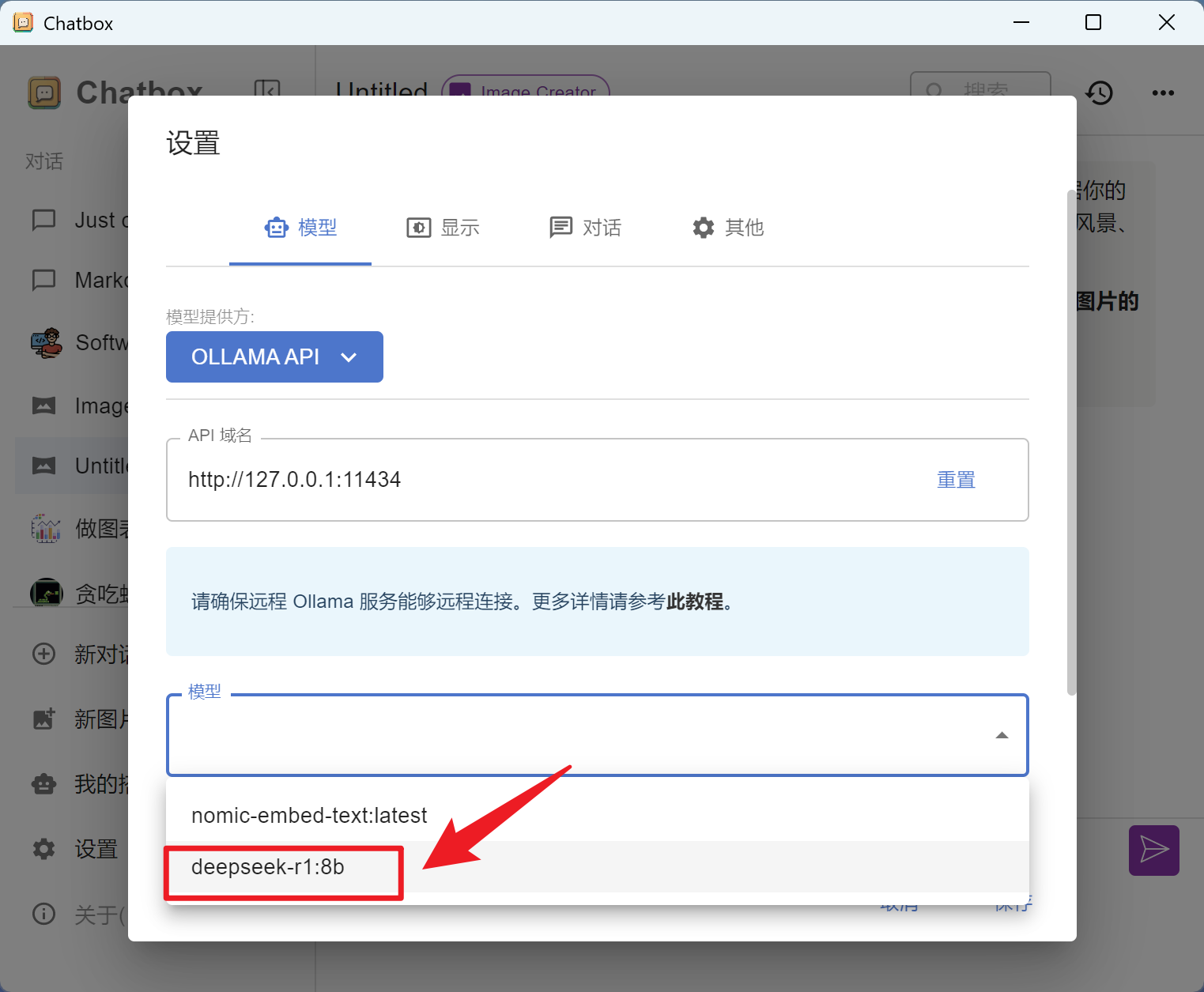

选择后,会自动带出“API域名”为 http://127.0.0.1:11434,即本地Ollama服务器接口地址。

在“模型”下拉框中,选择我们刚下载的“deepseek-r1:8b”

其他选项值,保持默认即可。

4. 使用Chatbox提问

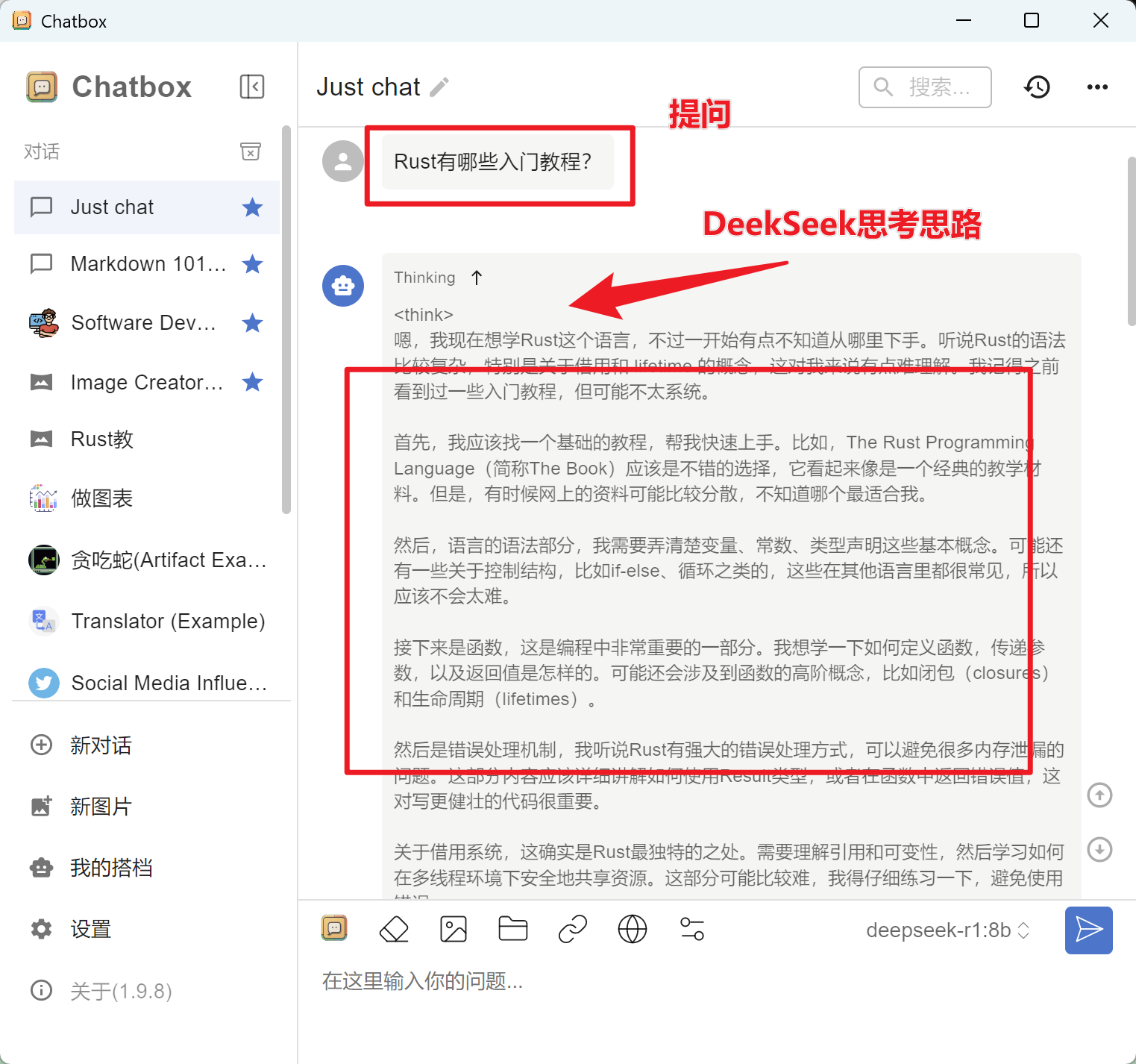

- 打开Chatbox窗口,输入你的问题,如:Rust有哪些入门教程?

- Chatbox会将请求发送到本地的Ollama服务器。

- 对话框中,首先会展示<think></think>文字片段,表示的是DeepSeek R1大模型的思考思路。

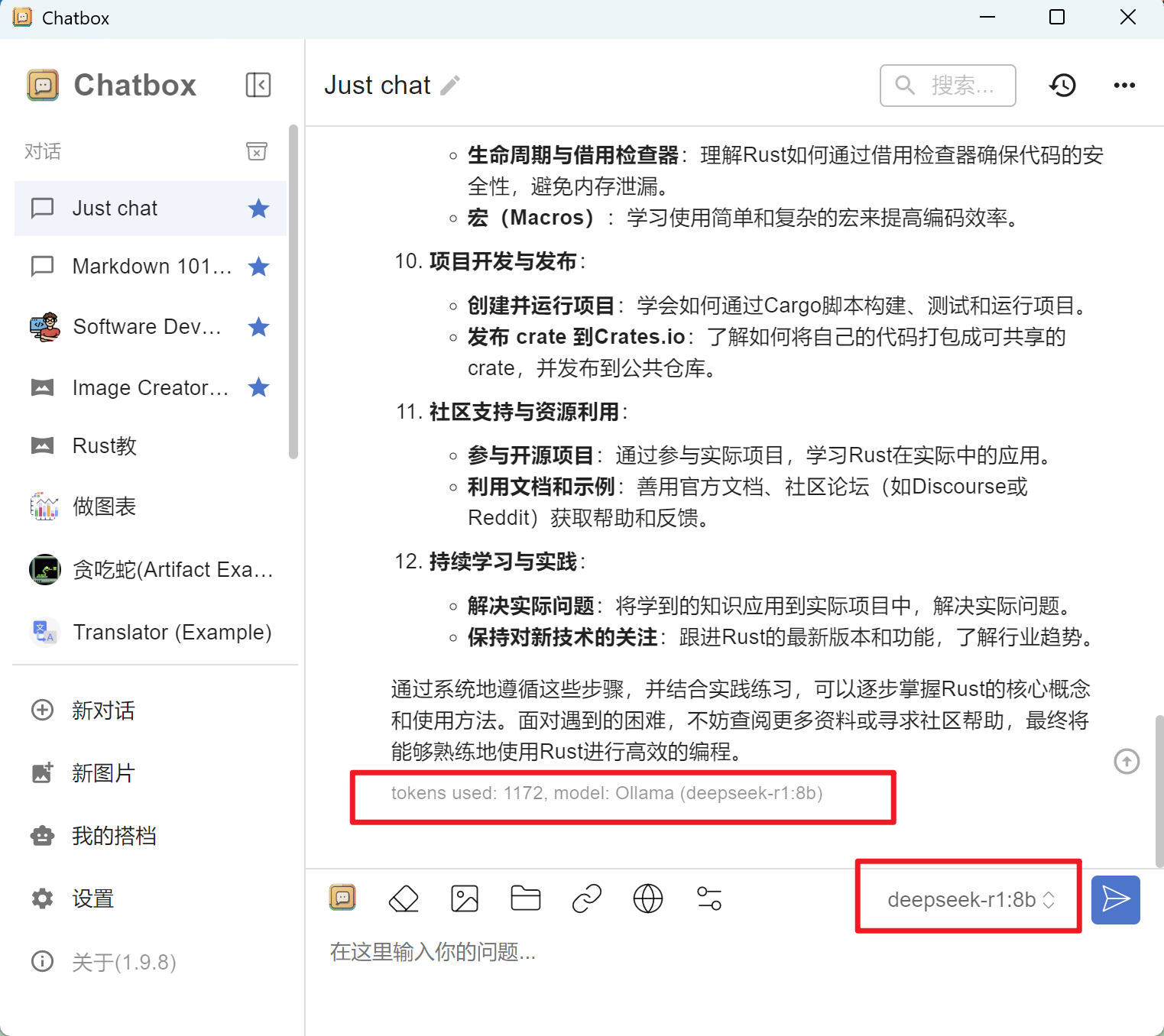

- <think>…</think>片段之后,才是DeekSeek回复的答案,最底下还展示了本次提问所花费的 token 数量,如下图所示:

5. 性能调优

注意:不同的模型规格,占用的电脑资源是不一样的,比如 DeepSeek R1,提供规格和硬件要求:

下表说明了各个版本的特点及适用场景:

其中最强悍的 671B 版本部署需要极高的硬件配置:64 核以上的服务器集群、512GB 以上的内存、300GB 以上的硬盘以及多节点分布式训练(如 8x A100/H100),还需高功率电源(1000W+)和散热系统。